山口行治(やまぐち・ゆきはる)

株式会社ふぇの代表取締役。独自に考案した機械学習法、フェノラーニング®のビジネス展開を模索している。元ファイザージャパン・臨床開発部門バイオメトリクス部長、Pfizer Global R&D, Clinical Technologies, Director。ダイセル化学工業株式会社、呉羽化学工業株式会社の研究開発部門で勤務。ロンドン大学St.George’s Hospital Medical SchoolでPh.D取得(薬理学)。東京大学教養学部基礎科学科卒業。中学時代から西洋哲学と現代美術にはまり、テニス部の活動を楽しんだ。冒険的なエッジを好むけれども、居心地の良いニッチの発見もそれなりに得意とする。趣味は農作業。日本科学技術ジャーナリスト会議会員。

株式会社ふぇの代表取締役。独自に考案した機械学習法、フェノラーニング®のビジネス展開を模索している。元ファイザージャパン・臨床開発部門バイオメトリクス部長、Pfizer Global R&D, Clinical Technologies, Director。ダイセル化学工業株式会社、呉羽化学工業株式会社の研究開発部門で勤務。ロンドン大学St.George’s Hospital Medical SchoolでPh.D取得(薬理学)。東京大学教養学部基礎科学科卒業。中学時代から西洋哲学と現代美術にはまり、テニス部の活動を楽しんだ。冒険的なエッジを好むけれども、居心地の良いニッチの発見もそれなりに得意とする。趣味は農作業。日本科学技術ジャーナリスト会議会員。

◆制作ノート

英国の経済学者エルンスト・シューマッハー(1911~1977年)の「スモール イズ ビューティフル」における中間技術の提案を、「みんなの機械学習」として実現するため、「スモール ランダムパターンズ アー ビューティフル」という拙稿を連載している。前稿では、経済予報と生活予報について考えてみた。経済予報の場合、景況感指数のように予測性がある経済指標が各種公表されているのでイメージしやすい。地域特性や業界特性を、経済データからどのように推測するのか考えてみた。生活予報はイメージしにくいけれども、以前は四季の移ろいに応じた、家族や集落の行事によって営(いとな)まれていたことを、地域のデータから読み取って予測し、広報することを考えてみた。「スモール ランダムパターンズ アー ビューティフル」は途中の画像以降なので、制作ノートに相当する前半部分は、飛ばし読みしてください。

「スモール ランダムパターンズ アー ビューティフル」のゴールは、結論を論理的に構築することではなく、生活世界において、データの世界との共存・共生・共進化に希望を実感することにある。近代的なモノの価値に従属する経済から、コト(サービスなど)の意味を重要視する経済への移行を時代背景として、近未来のデータサイエンス テクノロジー アンド アート(データの世界)が、人類の文明論的な変革をもたらす夢物語を、少なくともディストピアとはしない、複数の探索路を切り開こうとしている。物語のゴールにおいては、意味が認知される以前の「データ」そのものが、みんなの機械学習によって、「言語」とは別の、文明の道具になるだろう。

◆データインフラとしての予報

天気予報は、農業、漁業、観光業、食品店など、地域産業のインフラとして大いに役立っている。降雨予測や台風進路予測は、生活に不可欠な情報でもある。20世紀のアナログな時代では、長期や短期の天気予報は、時間的空間的に大雑把で、あまり当てにならなかった。スマホに、宇宙からの衛星画像やレーダー雨雲画像の予測図が、ほぼリアルタイムで配信される時代になって、ピンポイントの短期予報は当たらないほうが珍しくなった。長期予報については、地球レベルでの気候崩壊の影響もあって、不確実性が増大している。気候モデルの研究者である真鍋淑郎(まなべ・しゅくろう)さんが、2021年のノーベル物理学賞に選ばれ、より正確な長期予報の必要性が緊急の課題であることが、人類の共通認識になっている。天気予報は、英語では「ウェザーリポート」なので、英語圏では、そもそも天気を予測することに、あまり熱心ではなかったのだろう。

経済予報や生活予報が、しだいに正確になる天気予報のように、地域産業のデータインフラとなることを期待している。その地域におけるビジネスインフラであり、生活のしやすさを左右する公的なサービスとなるはずだ。その内容は前稿で序論を記載したし、今後の展開でより現実的な提案としたいけれども、本稿では、データの収集方法に焦点を絞って、ビッグデータと具体的にどのように異なるのか、スモールデータの可能性を記載してみたい。結論は簡単で、独占的なビッグデータではなく、プライベートなスモールデータを多数集めることから始めて、その有用性が明確になった段階で、パブリックなサービスに移行するという戦略だ。健康データに関連する類似のサービスは、すでにプライベートなデータサービス、パブリックなデータサービスともに実用段階になっている。健康データの場合も、ビッグデータのアプローチが中心なので、スモールデータによるアプローチは、今後の発展課題でもある。

◆スモールデータ・アプローチ

本論は個体差をともなうデータの機械学習をテーマとしている。本論の文脈では、ビッグデータとは、単純に個体数が多い(1000例以上)データを想定している。臨床試験では、大規模臨床試験や、電子カルテなどのリアルワールドデータがビッグデータに相当し、発生頻度の小さいイベントなどを検出する試みが行われている。経済データや生活データにおける代表的なビッグデータは購買履歴データで、個体差をうまく評価して、ロングテールな多品種少量販売を、ネットショップで有利に展開している。大量の文章や画像を使って機械学習するディープラーニングやチャットGPTも、不特定多数のデータという意味で、ビッグデータ活用例になる。

ビッグデータは、大量のデータを所有すること自体が困難で、コンピューターによるデータ処理も、スーパーコンピューターが必要になる。ビッグデータの利活用は、覇権国家の軍事利用や、ごく限られた大企業が中心といわざるを得ない。ビッグデータがもてはやされるようになる40年ほど前から、統計解析は、、科学技術系の論文などで必要不可欠ではあったけれども、主要な技術とは見なされていなかった。最近では、ビジネスにおけるデータ解析のニーズは高まる一方で、特に金融系のビジネスにおける、データサイエンティストという職種がもてはやされ、人材育成も需要視されるようになった。これらのデータ解析は、パソコンで十分取り扱える。機械学習は、特殊なビッグデータの解析手法として発展してきた。最近では、データサイエンティストの教育目的で、アルゴリズムを可視化して理解しやしように、スモールデータ・アプローチが試みられている。本論では、中小企業のビジネスで機械学習を活用することが目的なので、スモールデータ・アプローチが不可欠で、その近未来を模索している。

筆者の仕事関連では、10年ほど前に、30症例の臨床試験のデータから、200症例程度をシミュレーションで作成して、試験デザインを検討した経験がある。最近では、医療画像や遺伝子解析などで、症例あたりのデータ数が膨大になり、100症例で10,000変数といったデータの解析も珍しくない。もっとも、古典的な統計解析では、10,000変数を直接解析するのではなく、科学的な意味のある変数に絞ってから解析する。ディープラーニングなどの最近の機械学習では、画像データを直接解析できるようになった。しかし推定アルゴリズムに使われる膨大な数のパラメータの意味が不明で、責任ある判断は専門家が行う。スパースモデリングという統計手法で、ゼロと見なせるパラメーターを抽出して、パラメーター数を少なくする工夫もある。スパースモデリングで、ディープラーニングのパラメーター数を90%減少できて、計算機の負荷は減っても、パラメーターの意味を、人間が理解できる段階にはなっていない。筆者が推進しているフェノラーニング®の工夫は、スパースモデリングを、解析方法として使うのではなく、データの前処理、データマネジメントに使うという発想の転換だ。

◆スパースモデリング

スパースモデリングについては、多くの専門的な教科書があり、筆者は20年ほど前から、実務的にスパースモデリングを学習する目的で、Rという統計解析ソフトを使うようになった。筆者はSAS®の時代に統計を実務として学習し、機械学習などのAI技術のトレンドは、RからさらにPythonの時代となっている。製薬企業の臨床試験データの解析では、25年ほど前に、データマネジメントシステムに世界標準のデータモデルを実装して、日本で初めて実用化したことを、個人的にプチ自慢している。その経済効果(M&Aの意味で)が膨大であることを、当時の武田薬品工業とアステラス製薬の経営トップは気がついていた。次に与えられた課題が、医療画像を臨床試験データとして取り扱う社内ルール作りだった(システム構築、プロセス整備、社員教育など)。米国の規制当局(FDA=食品医薬品局)の協力を得るまでは頑張ったけれども、世界最大の製薬企業にとっても努力の限界が明らかで(得られるメリットが企業内では計算が合わないという意味)、20年ほど前にグループは解散になった。その当時、画像データの機械学習アルゴリズムの可能性と経済効果が理解できていれば、別の結論(製薬企業よりも大きな産業的インパクトがある)に至っていたかもしれない。

筆者がSAS®で解析し始めたころは、動物実験のデータか、臨床検体でも体外検査のデータだった。それでも、物理の実験と比べれば、データのばらつきが大きく、個体差の問題があることは明らかだった。当時は、SAS®だけが、順序統計量によるロバスト解析を実装していた。無前提に正規分布を仮定するのではなく、順序統計量で計算してみて、外れ値やバイアスによる誤差を評価することが、データ専門家としての日常だった。それでも、解析の結果(母集団の性質)に個体差が影響するのは、10回に1回程度だったと思う。問題なのは、分散の推定値で、解析手法によってかなりの差異があるのは日常茶飯事だ。スパース推定では、ロバスト推定の時代のように、無理に変数の数を少なくしたり、2値化したりしないでも、かなりばらついたデータでも安定した推定が可能になる。数学的に、順序統計量よりも深い安定化のメカニズムがあることを知ったのは、最近のことだ。英国で大学に在籍していた30年ほど前に、社会統計のグループが、スパースなデータには、ロジスティック回帰が適しているという話をしていて、全く理解できなかったことをよく覚えている。話している実務家も、数学的な意味は全く理解していない経験論だった。スパース推定が、機械学習において再評価されたのは偶然なのか、とにかく、実務家の直感は、理論を超えた部分があることは確かだ。

◆データでサイン(Data DeSign)

物理実験や臨床試験では、まず試験の目的を明確にしてから、どのようなデータを、どのように収集するのか計画して、実際のデータを収集する。合理的な計画なしに、データの収集をするのは、考古学のようなものだと、揶揄(やゆ)していた。しかし、最近の考えでは、科学的にデータを収集するという行為自体が、データをゆがめている可能性がある。無理に無作為化したり、プラセボ(偽薬)を投与したりするなどの行為は、倫理的に強く制限される必要があることも明らかになってきた。それでは、SNS(ソーシャル・ネットワーキング・サービス)のデータが、計画性や介入がないので、バイアスがないのかというと、データの問題以前に、社会や歴史が、経済的なバイアスで動いていることを見逃してしまう。筆者は、データを言語より優先する「強いデータ主義」の立場なので、データ収集の問題は、特に重要な課題として意識している。データが何を表現しているのかと問うことは、データを表現されたものとして、芸術作品のように取り扱う部分(表現型)と、データとしては意味不明な、自然観察のように取り扱う部分を、意識的に区別して考えることだ。もちろん、中間的なグレーゾーンがあって、そこがデータの価値そのものなのだけれども、グレーゾーンは、表現型と関連があるデータ(確率論的に独立ではないという意味で、必ずしも統計的な相関を意味しない)に限られると仮定しても無理は少ない。意味のないものには価値はないという、当然のような仮定ではあっても、意味がわからなくても、とにかく全てを独占しようという、歴史的にはよくある反動的態度は理解しているつもりだ。

前稿で、経済予報や生活予報のための、オルタナティブデータについて記載した。筆者の職業では、医薬品の有効性と安全性を評価するための、バイオマーカーに関する議論と重なる。例えば、心血管系疾患において、死亡リスクという真のエンドポイント(目的変数)に対して、血圧のコントロールという代替エンドポイント(サロゲート・エンドポイント)が確立されている場合に、バイオマーカーは、サロゲート・エンドポイントよりも、真のエンドポイントとの科学的関連性が疑わしい評価変数と位置づけられる。しかし、患者の立場では、個体差も含めて、患者本人のリスクを評価しうるバイオマーカーのほうが重要だし、製薬企業の立場では、臨床試験に組み入れられ、無作為化される患者集団の、個体差も含めた(性別、年齢、人種など)選定根拠のほうが重要になる。科学的(統計学的)根拠は、経済的要因に無関係ではないし、個人的な価値判断とは独立したものであることを、産業人として痛感している。バイオマーカーを観察研究に用いる場合には、例えば経済予報や生活予報においては、オルタナティブデータにトレーサーを混入させる可能性について、最近やっと思い至った。トレーサーとは、環境観察で安定同位体核種を使う実験のようなイメージだ。オルタナティブデータではない場合、貨幣にマーカーをつけるような行為で、倫理的にも、実験のバイアスを考えても、現実的ではない。意味が不明なオルタナティブデータの場合、意味不明なデータトレーサーを混入しても、少なくとも、倫理的な問題はないはずだ。どのようなオルタナティブデータに、どのようなトレーサーを混入するのか、もう少し考えてみたい。

どのようなデータを、どのように収集するのか、「データでサイン(DeSign)」と仮に呼んでおこう。あえて、意味が明確で、価値を訴求するデザインとは区別している。意味のない世界を探求するデータの世界は、現実の地政学や経済学とは異なり、未開拓な部分が多い。ジークムント・フロイト(1856~1939年)による無意識の世界の発見が、デカルトに始まる近代合理主義に大きなくさびを打ち込んだように、無意味なデータの世界を探求することは、意味や価値による言語的世界認識の限界を明らかにするだろう。フェノラーニング®による機械学習を活用する場合、データの個体差は何を表現しているのか考えて、その表現型を推定する目的で、十分に網羅的なデータを収集することが、データでサインに相当する。個体差をともなう推定したい評価変数は、定義からグレーゾーンに含まれる。その他多くの意味不明な変数を、スパースモデリングのように、説明変数から除外する決定は、フェノラーニング®の場合は、繰り返し計算によるデータマネジメントが終了してから行う。繰り返し計算では、外れ値や、欠測値などの例外的なデータの処理を、個体差の観点から自動的に行う。集団の複雑性に対応するパラメーター数は事前に設定するので、この設定もデータでサインに含まれる。どのようなデータを、どのように収集するのか、データ収集とデータ前処理の重要性が、データ解析に先行することさえ理解していただければ、。データでサインかデータデザインなのか、区別する必要はない。

◆個体差のまばらでゆらぐ多様性

多様性をどのように評価するのか、生物多様性という生態学の基本概念であっても数値評価は難しい(〈『生物多様性の多様性』共立出版、2018年〉など)。組織における人材の多様性など、多様性について語ることはできても、測定することはほぼ不可能だろう。多様な状態が、安定で居心地が良い状態と見なせるのは、まばらでゆらいでいる状態であると仮定してみよう。関係がまばらであることは、データの説明変数がスパース(大部分がゼロ)であることから、統計モデルとして簡潔に表現できる。時系列データがゆらいでいることは、周波数(f)のパワースペクトルが1/f2ではなく、1/fに比例すること、もしくは時系列データの変動が長期記憶を持つモデルで説明できることとして、データから明らかになる。個体集団の多様性を評価する方法として、個体差のあるデータを、まばらでゆらぐ統計モデルで表現できるという仮定は、データ解析と相性が良い。しかし、個体集団が多様であることを、均一ではないという意味で、論理的に理解すれば、上記の仮定とは相いれなくなる。個体集団が均一ではない、より強い意味で、分断されている状態は、個体集団として安定で居心地が良い状態ではないと解釈すれば、論理的矛盾はないとしても、データ論として不十分かもしれない。

データ解析の問題として、単純化して説明すれば、個体差のあるデータの場合、例えば、性別や年齢階層別に、層別解析することが一般的で、個体差集団が均一ではないと仮定していることになる。層別解析(事前に計画した部分集団という意味)や、事後的な部分集団解析は、データ解析としては一般的な方法であっても、問題点が多く、統計専門家が慎重に解析を行っても、解釈が確定できないことも多い。筆者が探求しているフェノラーニング®は、データ解析より前の、データマネジメント段階において、各個人の表現型変数を推定することで、個人ごとにデータのスパース性を評価している。データに個体差が生じるメカニズムにまで遡(さかのぼ)って、データの機器学習を行う試みだ。「ニュース屋台村」の記事では、哲学的な表現として、「個体差は、個体差の表現の個体差である」というテーゼを一貫して使ってきた。個体差は、個体集団内で、表現として増幅されることを意味するテーゼだ。フェノラーニング®は、このテーゼの技術的な実装になる。

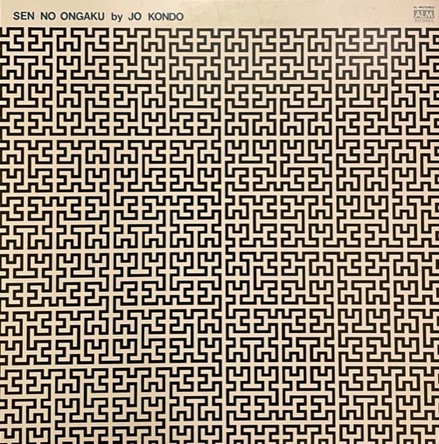

最後に、前稿で同時多点測定について言及した。まばらでゆらぐデータを測定しようとすると、同時多点測定が、最有力な方法であることはすぐに分かる。より身近な言葉では、同時多点測定は、ピクセルごとにデータ処理を行うデジタル動画にほかならない。音の場合は、立体的な音響効果が複雑な位相となるので、データとして活用するのには、動画よりも難しい。まばらでゆらぐ多様性のイメージは、拙稿第26回で紹介したシェルピンスキーのギャスケット(https://ja.wikipedia.org/wiki/シェルピンスキーのギャスケット)からの発想だった。まばらでゆらぐ音楽は、近藤譲の「線の音楽」がピッタリだと思う。とても個性的な、50年前のアナログな時代の、日本の現代音楽を、スマホアプリのSpotify®で聞くことができる。すごい時代になったものだ。

線の音楽 LPレコード1974年 筆者撮影 2023年9月17日

『スモール ランダムパターンズ アー ビューティフル』

1 はじめに; 千個の難題と、千×千×千×千(ビリオン)個の可能性

1.1 個体差すなわち個体内変動と個体間変動が交絡した状態

1.2 組織の集合知は機械学習できるのか

1.3 私たちは機械から学習できるのか

2 データにとっての技術と自然

2.1 アートからテクノロジーヘ

2.2 テクノロジーからサイエンス アンド テクノロジーへ

2.3 データサイエンス テクノロジー アンド アート

2.4 データサイクル

2.5 データベクトル

2.6 局所かつ周辺のベクトル場としてのデータとシミュレーション

3 機械学習の学習

3.1 解析用データベース

3.2 先回りした機械学習

3.3 職業からの自由と社会

3.4 認知機能の機械学習とデジタルセラピューティクス(DTx)

3.5 学習は境界領域の積分的探索-ニッチ&エッジの学習理論

3.6 機械学習との学習

4 機械学習との共存・共生・共進化-まばらでゆらぐ多様性

4.1 生活と経済の不確実性

4.2 生活と経済に関連する技術は、何を表現しているのか(前稿)

4.3 スモール データ アプローチ-個体差のまばらでゆらぐ多様性(本稿)

AI(人工知能)技術が飛躍するきっかけとなった機械学習は、データをコンピューターが学ぶ方法で、そもそも人間が不得意な分野だ。特に大量のデータ(ビッグデータ)の場合は、コンピューターと競争しようとする人間はいないだろう。人間の学習のように、知識を学習するのではなく、データを学習することに注意してもらいたい。多くの知識が、データに依存する時代となったけれども、AIが知識を体系的に表現する段階には至っていない。生成AIのように、AIが何かを表現しているかのような創作物を作り出したとしても、AIには表現の「場」が与えられていないし、鑑賞者は人間であってAI(生成AIには評価者アルゴリズムは実装されている)ではない。これはAI技術の限界ではなく、技術的な生活における、技術への期待の限界、近代的な生活の限界なのだと思う。近未来的な生活において、従来には考えもしなかった技術への期待が生まれたら、話は別になる。例えば、SNSにおけるニセ情報の検出技術が、政治家の発言の全てに適用されるようになれば、人間の言語能力を超えたAIが、AIの政治的表現の「場」を獲得するようになるかもしれない。筆者としては、AI技術の倫理的な規制が無意味だとか、不必要だと言いたいのではなく、近代文明における人間自身の倫理にも、近代文明の延長としてのビッグデータの未来にも、多くを期待していないだけだ。

機械学習の技術を学習したり、応用範囲を拡大するためには、ビッグデータでの成功事例を、スモールデータで説明することが望ましいし、実際にスモールデータによる機械学習の教科書(洋書)もある。すなわち、スモールデータの機械学習は可能であって、しかも、個体差が重要な意味を持つデータの場合は、スモールデータをたくさん集めるという、ビッグデータとは異なるアプローチが、特に有効になる。統計モデルの母集団やビッグデータは、普遍的な意味で、真の知識を推定しようとする。しかし、それぞれの個体にとっては、スモールデータによる、信頼できる推定で十分ともいえる。社会が分断され、経済的格差が増大するのは、政治や経済の問題よりも深い近代文明の限界かもしれない。近代において、真理を宗教から分離したとしても、論理の限界には、目をつぶってしまった。科学や技術の社会的な意味での無責任な態度、少なくとも説明責任をつくしていないことに起因する社会問題は少なくない。人間の理解能力を超える、量子論や複雑系およびデータの世界は、古典論理では不十分で、測度論以降の確率論による説明を必要としている。単純に言うと、現在の科学や技術では、未来予測の誤差要因を、社会的に説得力のあるようには説明できない。

AI技術が人間の能力を超えるのではなく、近代合理主義の限界を、AI技術で乗り越えようとしてみてはどうだろうか。近代文明が、地球環境や人間社会の大問題を、多数作り出したのは明らかであっても、近代文明による解決策が、近未来において期待にかなうという、科学的および統計学的な根拠はない。スモールデータは、データが不足している、と考えることをやめてみよう。本質的に不確定な、未来における属性(目的変数)の値を推定するためのデータは、空間的にも時間的にも、限られた範囲のデータから始めるしかない、という現実を、スモールデータから学んでみよう。個体差をともなうデータを、「神すなわち自然」によって与えられた属性の所与としてではなく、所与としての個体の近傍における、まばらでゆらぐ多様性、もしくは多様性の表現としてのデータと解釈してみよう。新しいデータ文明への移行が、スモールデータの機械学習とともに始まることを期待している。

AI技術や機械学習に限定することなく、人びとがコンピューターと共存・共生・共進化する近未来が、少なくともディストピアとならないために、どのような社会制度が必要なのか、過去の延長で考えるのであれば、簡単ではない。未来が過去の延長にあることは否定しようがないので、拙稿では、不必要かもしれない技術革新によって、未来に先回りすることを考えている。過去との共存という意味で、軍事力における圧倒的な成功体験と、持続不可能な地球環境と社会問題の両方を抱えながら、デカルト、スピノザ、ライプニッツに代表される、近代合理主義と共存している。人類で、一番最初にコンピューター(万能計算機)を構想したのは、ライプニッツだった。ライプニッツの時代から、300年以上が経過して、日常的にスマホを使い、人びととAI技術が共生する時代になっている。ニュートン力学によって、砲弾の軌道が計算できるようになり、ロケットやドローンが軍事利用される時代になったけれども、核爆弾との共生や共進化は、おそらく無理だろう。共生は、現時点で相互に利益がある状態であって、相応に安定している状態だ。共進化の場合は、相互に未来の状態においてもポジティブに影響を与え合うことを意味している。生物における進化論的な時間は、数億年という単位になるとしても、技術や文化における共進化であれば、数百年の時間で評価ができるだろう。コンピューターとの共進化も、近未来というよりも、文明論的な社会変革の時間軸で考えて、300年の共存・共生の結果として再考してみたい。コンピューターと人間との共進化は、1000年以上未来であっても、持続可能な地球環境と社会制度を構想するときの、コンピューターの役割といった意味合いになるだろう。

スモールデーターは、個体の近傍のデータであって、おそらくデジタル時間分解能のデータになる。個体相互の関係が、目的変数を予測するための説明変数の数という意味で、まばらな状態を仮定している。まばらなので、空間的な距離が離れていることがありうるし、個体の近傍を、データから見いだすことは容易ではないだろう。フェノラーニング®では、個体の近傍を、各個体の表現型変数をスパ-ス推定する説明変数と、推定精度が良好な個体集団の組み合わせとして、繰り返し計算によって標準化をすすめながら、データマネジメントの段階で構成している。目的変数の解析は、表現型変数で構成された、各個体の近傍で行う。おおまかには、表現型変数で調整された再標本化法(https://ja.wikipedia.org/wiki/ブートストラップ法)のイメージだ。新規な機械学習アルゴリズムとしてのフェノラーニング®は、データ前処理を自動化していることが最大の特徴であって、データマネジメント業務の実務経験から発想したものだ。世界的に見ても、とてもユニークな技術であるため、少人数のグループで丁寧に育てて、(パートナー企業と)知的財産権を確保してから、AI技術のレッドオーシャンに挑戦してゆきたい。

筆者が25年前に着任したデータマネジメントグループは、女性だけの職場だった。50年前であれば、タイピストの職場のようなものだ。もちろん、データマネージャーの適性に、性差はない。ワープロが発明されて、タイプライターがなくなったように、フェノラーニング®によって、データマネジメントグループが不必要になるかもしれない。しかし、データマネージャーがデータを前処理する適性は、フェノラーニング®の発展に不可欠だ。筆者のデータマネジメントグループにおける、歴史的に二度とない実務経験が、AI技術の技術革新に役立つとしたら、ユニークな技術となることは確かだし、だれにでもどこにでも、AI技術を変革するチャンス、すなわちコンピューターとの共進化の可能性があることの実証となる。

◆次回以降の予定

4.4 まばらでゆらぐ多様性の過去・現在・未来

4.5 生活の不確実性を予測する

4.6 弱い最適化-脆弱性/反脆弱性からのスタート

4.7 ひとつのビッグ予測、たくさんのスモール適応

--------------------------------------

『みんなで機械学習』は中小企業のビジネスに役立つデータ解析を、みんなと学習します。技術的な内容は、「ニュース屋台村」にはコメントしないでください。「株式会社ふぇの」で、フェノラーニング®を実装する試みを開始しました(yukiharu.yamaguchi$$$phenolearning.com)。

[…] 事に遡(さかのぼ)って、『みんなで機械学習』第28回「データでサイン」(https://www.newsyataimura.com/yamaguchi-100/)で考えた「スモールデータ・アプローチ」の教科書(※参考1)を学習教材 […]