山口行治(やまぐち・ゆきはる)

株式会社ふぇの代表取締役。独自に考案した機械学習法、フェノラーニング®のビジネス展開を模索している。元ファイザージャパン・臨床開発部門バイオメトリクス部長、Pfizer Global R&D, Clinical Technologies, Director。ダイセル化学工業株式会社、呉羽化学工業株式会社の研究開発部門で勤務。ロンドン大学St.George’s Hospital Medical SchoolでPh.D取得(薬理学)。東京大学教養学部基礎科学科卒業。中学時代から西洋哲学と現代美術にはまり、テニス部の活動を楽しんだ。冒険的なエッジを好むけれども、居心地の良いニッチの発見もそれなりに得意とする。趣味は農作業。日本科学技術ジャーナリスト会議会員。

株式会社ふぇの代表取締役。独自に考案した機械学習法、フェノラーニング®のビジネス展開を模索している。元ファイザージャパン・臨床開発部門バイオメトリクス部長、Pfizer Global R&D, Clinical Technologies, Director。ダイセル化学工業株式会社、呉羽化学工業株式会社の研究開発部門で勤務。ロンドン大学St.George’s Hospital Medical SchoolでPh.D取得(薬理学)。東京大学教養学部基礎科学科卒業。中学時代から西洋哲学と現代美術にはまり、テニス部の活動を楽しんだ。冒険的なエッジを好むけれども、居心地の良いニッチの発見もそれなりに得意とする。趣味は農作業。日本科学技術ジャーナリスト会議会員。

◆制作ノート

英国の経済学者エルンスト・シューマッハー(1911~1977年)の「スモール イズ ビューティフル」における中間技術の提案を、「みんなの機械学習」として実現するため、「スモール ランダムパターンズ アー ビューティフル」という拙稿を連載している。前稿までは、「データにとっての技術と自然」というテーマで、データサイエンス(データの科学技術)よりもひとびとの生活に近い、技術やアートとしてのデータの世界を探訪した。前稿をふり返りながら、本稿への足掛かりを探して、「制作ノート」としている。本稿は途中の画像以降なので、制作ノートは、飛ばし読みしてください。

「スモール ランダムパターンズ アー ビューティフル」のゴールは、結論を論理的に構築することではなく、生活世界において、希望を実感することにある。古典的なモノの価値を問う経済から、コト(サービスなど)の意味を重要視する経済への移行を時代背景として、近未来のデータサイエンス テクノロジー アンド アート(データの世界)が、人類の文明論的な変革をもたらす夢物語を、少なくともディストピアとはしない、複数の探索路を探そうとしている。物語のゴールにおいては、意味が認知される以前の「データ」そのものが、みんなの機械学習によって、「言語」とは別の、文明の道具になるだろう。

◆AI技術と機械学習

最近では、チャットGPT関連のAI(人工知能)記事が、大手新聞を賑(にぎ)わしている。生成AIを自然言語に応用したチャットGPTは、確かに画期的な技術で、産業分野での応用も期待される。しかしいうまでもなく、現在のAI技術は発展途上で、多くの問題点を抱えている。特に、社会的な影響については、予測不能な問題が多い。巨大IT企業間の開発競争というよりも、覇権国家間の経済競争として、政治的な議論になっている。「ニュース屋台村」の編集長いわく、「このように脅威をことさら強調する書き方は記事にする際の常套(じょうとう)的なやり方で、大上段に振りかぶると、いわゆる“すわり”がよくなります」とのことだ。筆者のような素人記者では、「すわり」のよい記事を書くことは出来ないけれども、科学論文にしても新聞記事にしても、かなり誇張されていて、まずは興味を持ってもらい、本当に言いたいことや伝えたいことは、細部に隠されていることがよくある。AI技術の場合は、機械学習技術がAIの驚くべき能力の根幹にあるので、まずは機械学習について考えてみたい。

機械学習技術について、機械が自動的に(もしくは自律的に)学習するというイメージを持っていたとすれば、それは本当に驚くべき機械であって、近未来に実現できるかもしれないSF(サイエンスフィクション)だ。現在の機械学習技術は、大量のデータを、自動的に(機械的に)データマネジメントする技術に過ぎない。この見立ては、筆者独自のもので、あまり聞いたことがないだろうし、意味がわかりにくいかもしれない。データマネジメントとは、データベースと解析用データセットを作成する作業のことで、データ解析の作業者1人に対して、データマネジメント作業者3人ほどの作業量となる。例えば画像データベースの場合、画像の特徴量を抽出して、画像データを統計解析できるように整理する作業に相当する。最近大活躍しているディープラーニングという機械学習技術では、画像データを超多層のパーセプトロン(画像変換する結合パラメーターの行列)に入力して、例えば、画像を判別する解析において、画像データを蓄積しながら判別のためのパラメーターを最適化している。古典的な統計解析の理論では、入力データのデータ属性(変数)の数以上に多量のパラメーターを用いると、オーバーパラメタリゼーションという現象が発生して、推定性能が向上せずに、計算が不安定になってしまう。ディープラーニングではこの常識を覆して、画像データを蓄積しながらパラメーターを最適化するという、データマネジメント業務を自動化(プログラム処理)している。ディープラーニングよりも古典的な機械学習技術であるランダムフォレストでは、例えば、1000個のデータからランダムに500個のデータを抽出して、抽出したデータで判別木(デシジョンツリー)を作り、この処理を例えば1000回繰り返して、解析結果を統計処理している。どこが機械学習なのかと不思議に思うかもしれないけれども、模擬的にデータセットを繰り返し解析して、最適な解析結果を学習していることに相当する。やはり学習というよりは、模擬的な解析用データセットを自動的に(プログラムで)作成するデータマネジメントの工夫といったほうが適切だろう。

データマネジメントを自動化するためには、データの性質に関する理解が重要で、個体差を含むデータの場合は、個体差を表現する変数(例えば性別とか年齢)を十分な精度で推定しうるデータ(網羅的データ)のデータマネジメントを自動化する機械学習技術として、筆者独自にフェノラーニング®を開発している。医学や経済学では、個体差が意味のあるデータが重要になる。工学や物理学では、個体差が重要ではないけれども、予測が困難なデータにおいて、機械学習技術が応用されている。筆者は「薬効の個体差とは何か」という問題を考えながら、40年間、データ解析の仕事をしてきた。機械学習を、データマネジメントの自動化ととらえ直すことで、フェノラーニング®にたどりついている。フェノラーニング®がディープラーニングのように、経済的にも政治的にも、大きなインパクトのある技術であるのなら、なぜもっと発展しないのか、注目されないのかと、いかがわしく思われるだろう。筆者なりに、世界最大の製薬企業で働いた経験から、アイデアだけでは、スケールの差異は乗り越えられないことをよく知っているつもりだ。特許などの知的財産権にしても、スピード勝負になれば、大企業にはかなわない。経済的な競争だけではなく、政治的な覇権争いに、データサイエンスが巻き込まれることには、もっと大きな拒否感がある。データサイエンスを社会データに悪用すれば、核爆弾以上の、人類を絶滅させる技術となる可能性が大きい。データにとっての自然(自然科学としてのサイエンス)とは何か、個体差をどのように理解するのかといった、哲学的な問いから始めているのには、このような筆者なりの個人的な配慮がある。フェノラーニング®は大きな空振りかもしれないけれども、データサイエンス テクノロジー アンド アートには、産業革命以降の近代文明を乗り越える、大きな可能性があるのは確かで、人類存続にとって唯一の可能性かもしれない。

◆局所的で網羅的なデータ

ネットワークに接続したセンサー技術(IoT)や、10億人規模のスマホ入力などで、コンピューターにとって、データ取得・記憶のコストが限りなくゼロ(電気代程度)に近づいている。いわゆるビッグデータが、AI技術の推進役であって、ビッグデータとAI技術は、巨大IT企業と覇権国家に独占されやすい。しかし個体差が意味のあるデータの場合、個人情報保護の規制もあって、個人を特定できるデータは匿名化されている場合が多い。ビッグデータの全体は必要はないし、個人のために利活用できる局所のデータで十分だ。私個人のデータを含む、私の周辺のデータをうまく定義できれば、局所的なデータを接続して、全体のデータの中での私の場所を見いだすこともできるだろう。

個体のデータにおいて、局所的なデータを定義したり発見したりする場合、類似する個体の「距離」を数値化することがよく行われる。個体の類似性が、すべての個体間で単一の距離関数によって定義されるとは限らない。類似した個体間だけで、局所的な類似性を評価して、離散的なネットワークを構成することで、個体間の距離をネットワーク上の離散的な距離(例えば、最短ノード数など)を定義することも考えられる。ネットワーク上の類似性の場合、新たな個体によって離れた集団間に近道が作られて、ネットワークの構造が大きく変化する場合もある。個体データのネットワーク表現は、発見的な方法に適している。筆者が考案したフェノラーニング®では、個体間の類似性よりも、個体集団における予測誤差を評価して、集団の構造を学習しながら、データマネジメントを自動化している。外れ値を含む個体を、予測誤差を基準としてプログラムで自動処理しているイメージだ。何を予測するのかということが問題の本質で、例えば性別や年齢、疾患の有無など、個体が集団の中で何を表現しているのかということを考察して、それらの表現型変数をデータから推定するのに十分な個体データを網羅的データと考えている。予測という場合、治療の予後予測のように、時間が関係するので、時間が関係しない(想定している期間の中で)変数の場合は、推定とよんでいる。個体差の個体間変動の場合に推定、個体内変動の場合に予測、と使い分けているけれども、個体間変動と個体内変動が複雑に交絡(こうらく)する場合もあるし、因果関係が不明な場合も多いので、あまり気にしないでもよいだろう。フェノラーニング®は、個体差が意味のあるデータで、局所的で網羅的なデータのデータ解析を目的として、データマネジメントと統計解析を統合した新たな機械学習法だ。

◆フェノラーニング®

フェノラーニング®は、健康データや経済データのように、個体差をともなうデータにおいて、個体差を測定誤差としてではなく、個体差を身体や地域の場所の問題として、より積極的に評価して、問題解決の糸口を見いだすことをめざしている。古典的な機械学習法は、統計解析の方法を応用して、パソコンで数分から数時間の計算量だった。最近発展が目覚ましい機械学習法で、AI技術の計算エンジンとなっているディープラーニングでは、本格的な専用計算機を使って、数週間の学習を行うようになってきた。膨大な計算(予習)をして、驚くべき予測性能を発揮している。フェノラーニング®は、その中間ぐらいの計算量で、パソコンで半日程度の計算を、結果を見ながら探索的に繰り返している。フェノラーニング®の考え方がまとまる以前の段階で、臨床試験の公開データべ-ス(ClinicalTrials.gov)をデータマイニングしていた2010年当時は、探索的な解析を1週間ほど繰り返して、プロジェクト提案などにまとめていた。探索的な解析に時間がかかるし、解析作業者の経験に依存していたので、計算方法を特許出願はしたものの、コンサルテーションの道具に使う程度で、産業的に役立つような応用を見つけることができなかった。当時から10年が経過して、機械学習法として再定義してみると、様々な産業応用が期待できることに気が付いた。

健康データに関しては、臨床試験のデータを補完する意味で、最近話題となっているRWD/RWE(real world data/real world evidence)への応用や健康食品など、個の医療を実現するために、個体差を積極的に評価するフェノラーニング®の役割が期待される。しかし、性別や年齢、さらに身体各部位を正確に評価する網羅的データとしては、MRIやX線CTなどの医療画像データが最良であって、医療画像データの機械学習は、最先端の医学研究に相当する。みんなで機械学習するのには重すぎる課題だ。体重計や体組成計のデータは、ダイエットに取り組む人びとの、一喜一憂ではあっても、網羅的データとまではいいがたい。左右のバランスや姿勢、運動負荷などを加味して、データ収集方法を工夫する必要があるだろう。脳波データに関しては、神経活動を直接コンピューターに入力する「デバイス」としての可能性が期待されるけれども、これも最先端の医学研究だ。最先端の医学研究であれば、常在性ウイルスの一斉分析が最も有望だと思う。ウイルスは人間の理解をはるかに超えているので、機械学習の活躍が期待される。みんなで機械学習としては、飲酒後の呼気中のアルコール濃度を測定して、肝臓の機能や心肺の機能を評価することにチャレンジしてみたい。日常生活に直結していて、大きな個体間変動と個体内変動があるので、フェノラーニング®の学習課題として手ごろだろう。機械学習法も学習しないと、進歩がない。

◆Web3.0時代の機械学習

暗号資産のブロックチェーン技術をWeb(インターネット閲覧サーバー)に組み込んで、信頼性を保証するインターネットサービスをWeb3.0と呼ぶらしい。実際は、暗号資産を開発者や利用者の経済的なインセンティブとして、SNS時代の独占的巨大IT企業に対抗する新興IT企業群の活動といった程度のことだろう。そうはいっても、確かに独占的巨大IT企業(プラットフォーマー)の影響力は、覇権国家に拮抗するほどに絶大なものとなっていて、未来のAI技術を自社サービスに惜しげもなく注ぎ込んでいる。インターネットや社会の信頼性など、SNSビジネスのおまけ程度にしか考えていないのだから、Web3.0に期待する気持ちも理解できる。日本の内閣官房デジタル市場競争本部が推進している「Trusted Web」は、ブロックチェーン技術に限定することなく、むしろ電子認証技術の延長上で、信頼性が保証されたインターネットサービスを模索している。経済的なインセンティブが政府の助成金というのでは、Web3.0のように派手な振る舞いはできないとしても、昨今の経済活動が、インターネットによるサービス経済を主戦場とすることは確実なので、政府としても、技術の属国状態や鎖国は避けたいのだろう。

インターネットや社会の信頼性について、哲学的な反省ではなく、技術や政治を優先するのは、SNS、Web3.0、もしくは中国のような監視社会であったとしても、近代文明が過度に個人主義化してしまった問題を見失っている。大統領であっても社長であっても、個人の経済的および社会的な犯罪行為は無くならないし、覇権国家であっても、戦争も市場破綻(はたん)も防止できない。筆者の拙稿における近代文明批判としては、社会の信頼性を考える際の、予測と表現のアンバランス、場所性のくりこみ理論(マクロとミクロの中間層)の不在、に集約される。

社会は、集団としての性質を持っているので、個人相互の契約だけでは理解できないし、社会的な信頼を形成することは出来ない。予測は正確なデータさえあれば、個人でもできるけれども、表現は、集団の中でしか成立しない。表現は優れて社会的な行動であって、企業などの組織が行う表現には、組織の集団(例えば業界)の内部規範、および集団と集団の関係が表現されている。予測と表現のアンバランスは、経済活動(例えば投資)における、集団の内部規範(社会性)と、個人の利潤追求の自由のアンバランスの問題でもある。

家族における個人の立場は複雑だとしても、居住地域を小さい区画から、行政単位などで順次拡大することは日常的に行われている。行政単位ではなく、メッシュ統計で、最終的には全地球まで拡大して、気候変動を予測することが可能な時代だ。体の各部位も、血流と神経によって、分散的に制御され、多重にネットワーク化されている。Webの世界における「信頼性」についても、もっと考えることはたくさんあるだろう。

具体的に指摘してみよう。グローバルなネットワーク志向のWeb3.0に、地域性が全く考慮されていないことは当然だとしても、Web3.0の開発者や利用者の内部で、集団としての文化の醸成が期待できないことは、社会的な不安定要因だ。個人的にWeb3.0で儲けることは出来るかもしれないけれども、同時に、損失を被るリスクもある。そもそも社会性が欠落している技術であるため、社会的には予測不可能な部分が多い。

Trusted Webにおいても、産業界におけるデータ流通のサイロ化が指摘されているのに、業界団体の役割が全く考慮されていない。企業の集団(大部分は零細・中小企業)を、地域や業界によって「くりこむ」ことで、最終的に政府に行きつく道筋が見えない(発想がない)。Web技術に実装される機械学習技術が、個人と全体しか理解できないので、個人や企業に対するサービスは構想できても、集団レベルで調整されたサービスとはならない。ネット犯罪を未然に防ごうとする、受け身の対策でしかない。

フェノラーニング®によって、業界レベルや地域レベルでの集団の「表現」を積極的に評価して、Web技術に実装できれば、自然に社会的な意味での信頼性が醸成されるだろう。企業のWebが、業界データモデルと、地域データモデルを実装していれば、業界や地域レベルでデータを集約して表現できる。すなわち、天気予報のようなサービスとして、局所的に信頼できる検索サービスやディレクトリーサービスを、Web上で自動的かつ分散的に提供できるようになる。業界団体や商工会など、局所的な組織の集団が、それぞれ工夫したデータモデルを定義して、Webサーバーに実装し、フェノラーニング®によって機械学習できるようになれば、その仕組みは、商標権、著作権、ビジネス関連特許などの知的財産権として保護される。SNSプラットフォームとは異なって、局所的なデータモデルが明示的に定義されていることで、信頼性も高まるはずだ。

スケールを調整しながら、ミクロとマクロの中間層が探索できるようになれば、近代文明が作り出し山積みにされた社会問題を、中小企業のサービスと結び付けて、天気予報程度には信頼できる社会指標を使って、局所的で重層的にくりこまれた解決案を作るという、膨大な数の前向きな仕事が可能になる。社会的な信頼性とは、一過的な損得ではなく、世代を超えて続く前向きな仕事によって支えられるのだと思う。

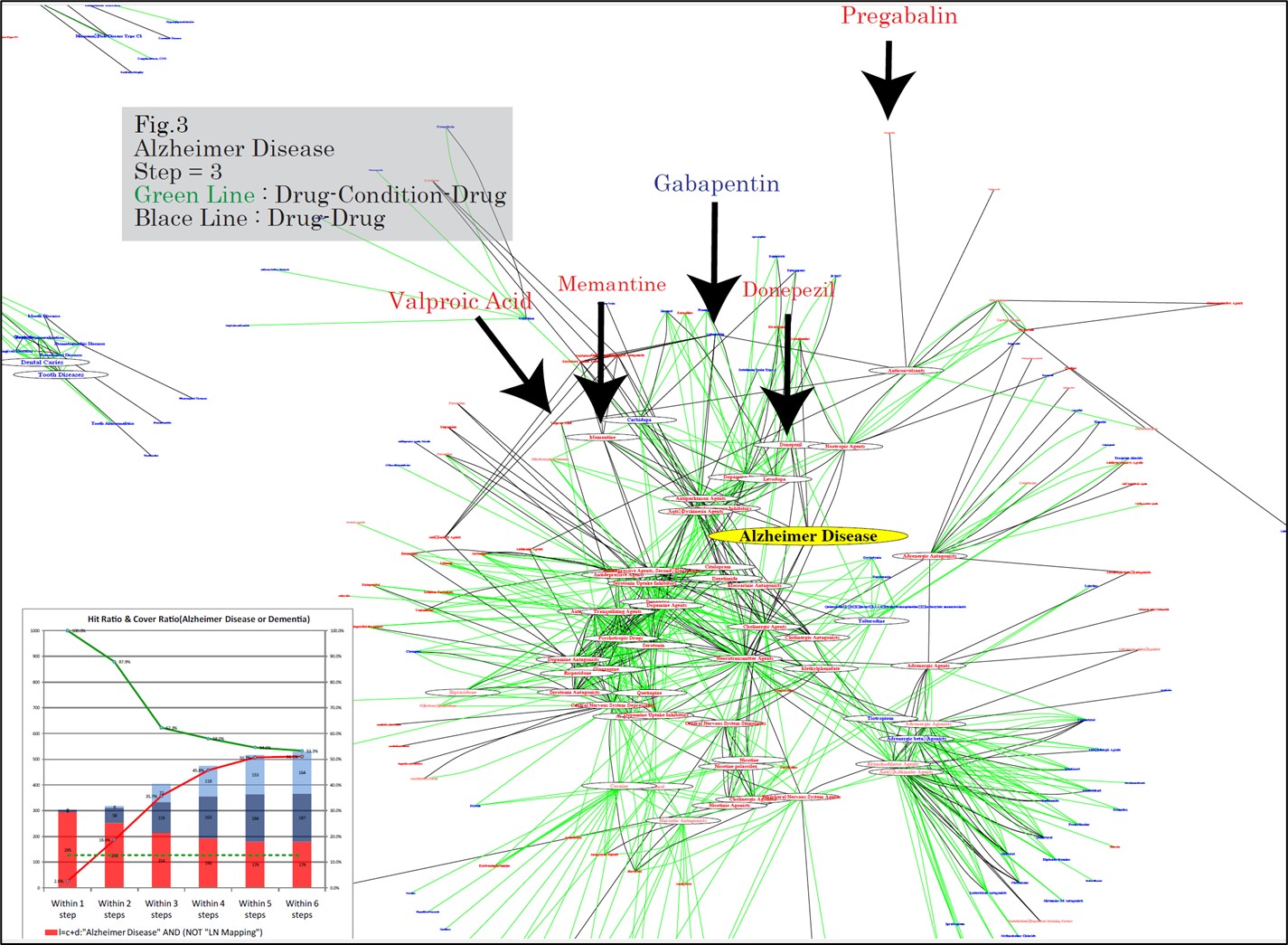

(国際学会InCoB10における筆者ポスター発表の一部、技術内容は特願2010-21550参照)

『スモール ランダムパターンズ アー ビューティフル』

1 はじめに; 千個の難題と、千×千×千×千(ビリオン)個の可能性

1.1 個体差すなわち個体内変動と個体間変動が交絡した状態

1.2 組織の集合知は機械学習できるのか

1.3 私たちは機械から学習できるのか

2 データにとっての技術と自然

2.1 アートからテクノロジーヘ

2.2 テクノロジーからサイエンス アンド テクノロジーへ

2.3 データサイエンス テクノロジー アンド アート

2.4 データサイクル

2.5 データベクトル

2.6 局所かつ周辺のベクトル場としてのデータとシミュレーション(前稿)

3 機械学習の学習

人工知能技術は、近代哲学の巨人、17世紀ドイツのゴットフリート・ライプニッツが夢見たコンピューター技術の究極的な目標であって、全ての計算可能な問題を解決するはずだった。しかし、産業革命以降の近代文明は、原理的に計算不可能な問題(カオスなど)も含めて、膨大な数の社会問題を作り出し、地球には修復不可能な環境破壊をくりかえしている。すなわち、完璧なAI技術が完成しても、解決できる問題はごくわずかで、作り出す問題のほうが大きいことを、ライプニッツは気が付いていたのだろうか。近代文明の妄想や錯覚を修正しない限り、社会的及び経済的な犯罪を繰り返す人類の、近未来における生存確率は限りなくゼロに近づくだろう。ユートピアは特に必要ではないとしても、現在から未来への、明らかなディストピアには抵抗を示したい。そのために、AI技術を一部の技術者と権力者にゆだねるのではなく、AI技術の頭脳である機械学習技術を「みんなで」学習して、AI技術への幻想を取り除き、仮想現実には取り込まれないようにして、現実の問題を直視したい。機械学習を学習することで、近代文明とは決別する「データの世界」の新しい可能性が見いだされるだろう。ライプニッツは終生「個体性」の問題を考えて、モナドロジーという難解な哲学を遺(のこ)した。筆者は、ライプニッツはモナドとして他界したのではなく、世界で最初のスピノザ主義者として、個体としての死を迎えたのだと思う。近代哲学における哲学の自由を生きた、オランダの哲学者バールーフ・デ・スピノザ(1632~1677)は、現代の近代文明にとっては異端者であり、言語の極限において、語りえない世界を語って他界した。「データの世界」とは、スピノザが語りえなかった、ライプニッツが夢見たオルタナティブな近代文明であって、「個体」とは何かという問いに答えようとする。近代経済学や現代医療の限界を乗り越えてゆく、別ルートであって、「データの世界」の冒険者たちの活躍を待っている。

機械学習というと、コンピューター(計算機械)が自動的に学習するかのように錯覚してしまう。囲碁などのゲームや、文章の穴埋め問題など、AIが自動的に学習しているかのようではあっても、自動的に膨大な対戦棋譜を作成したり、自動的に膨大な文章の穴埋め問題を作成して、正解の推定精度を統計的に高めているだけのことだ。機械的な作業を学習というのであれば、学習かもしれないけれども、小学生が行う学習のごく一部でしかないことは確実だ。筆者の見立てでは、最近の機械学習の成功は、膨大な量のデータを、統計処理するための前処理(データマネジメント)を自動化したことにある。データ解析業務を行っていると、統計解析作業者1人に対して、データマネジメント作業者3人程度の作業量であることが通常なので、データマネジメントを自動化するということは画期的だ。しかし、データマネジメントを自動化する方法は、データの性質に依存するし、現在試みられている方法は、自動処理アルゴリズムの5%以下に過ぎないものと思われる。医療データや経済データなど、個体差が重要な意味を持つデータにおいて、個体差をモデルとして含むデータの場合は、単純な正解は無いので、現在の機械学習では不十分な結果(予測性能)しか得られないことを考えると、5%以下というのも甘い評価かもしれない。医療の予後予測や、経済予測が、天気予報程度に信頼できるものとなるためには、機械学習を学習して、適切なデータを収集しながら、「役立つ」サービスとして実感できるようになるまで、試行錯誤を繰り返すことになるだろう。

3.1 解析用データベース

データ解析で生計を支えて40年以上になる。EXCELで手軽にデータ解析ができるようになったので、データ解析の専門家は不必要になったかというと、その逆で、大学にデータサイエンス学部ができるほど、求人がある。筆者のような旧人類にとって、コンピューターによるデータ処理というと、データベースが中心になる。データベースの代表格が1970年にIBMのEdgar F. Coddが提唱した「リレーショナル理論」に基づいて作られた関係データベースだ。データを表(テーブル)単位に格納し、それらのデータを検索・追加・削除するためにSQL言語を使用する。関係データベースをIT技術の中心としたオラクルというIT業界の巨人は、旧人類にとっては、現在のGAFAのような存在だった。

オラクルのような、関係データベース管理システム(RDMS)を使ってデータを収集すると、データの定義が明確になり、データの品質管理も容易になる。関係データベースのデータを使ってデータ解析する場合、解析に必要なデータを抽出して(品質管理のためのデータなどを除外する)、解析しやすいように前処理して、解析用データセットを作成することが通常だ。統計解析の専門家が、SQL言語やデータ定義の詳細を理解する必要はないので、合理的ではあるけれども、この前処理の手間は相当なものとなる。データ定義をデータベース間で統一したデータモデルに従って記述すれば、この前処理を自動化できる。臨床試験のように複雑なデータの場合は、このデータモデル自体が膨大なものとなって、業界全体(世界の規制当局も含めて)で保守管理することになる。それでも、解析用データセット作成の前処理を自動化できるメリットは大きい。

GAFAの時代となって、インターネットに記録された情報をデータソースとする場合、インターネットのHTML形式の情報に、データ定義を追加したXML形式のデータを直接データベースとして使用する技術が発展している。最近の機械学習では、もう一歩進んで、解析用データベースを自動的に作成するようになった。自動的に作成するとはいっても、シミュレーションでデータ自体を作成する場合は、データ定義が自明なので容易なのだけれども、実際に測定されたデータの場合は、画像データのように、データ定義が物理的で単純な場合に限定されている。脳の画像データ処理をモデル化した、パーセプトロンの理論は、1960年代から研究されていたけれども、中間処理層を超多層化した最近のディープラーニング技術では、画像データに限らず、タンパク質の立体構造や文字データまでも処理可能になり、解析用データベースの作成が、解析結果の最適解の探索アルゴリズムとして自動化されるようになった。データベース作成(データマネジメント)とデータ解析が融合された新時代のデータ解析として、機械学習が注目されている。

ディープラーニングは、専用のスーパーコンピューターを用いて、画期的な成果を演出しているけれども、具体的にどこが稚劣なのか指摘してみよう。タンパク質の立体構造予測は、ノーベル賞級の画期的な科学的成果であることは確かだ。しかし、タンパク質の立体構造が正確に予測できたとしても、タンパク質の生理的な作用がわからないのでは、何の役にも立たない。タンパク質の立体構造から、タンパク質の生理的な作用を予測できるというのは、近代的科学のドグマ(科学的仮説)でしかない。筆者の見立てでは、おそらく、予測不可能なはずだ。タンパク質の立体構造予測には個体差の問題はない。しかし、タンパク質の生理的な作用には、種差どころか、個体差の問題が立ちはだかっている。生理的というのは、生きている状態でという意味で、生きている状態そのものに、個体差があるからだ。医療で問題となるのは、病理的な状況であって、生きていることすら危うくなった状態だ。科学が一歩一歩前進しているというのは幻想であって、後退しているかもしれないし、科学が排除している問題こそ、本質的な問題かもしれない。科学が役に立ったのは歴史的な事実であったとしても、どのような役に立ったのか、科学技術として変質した科学が関与したガス室での大量毒殺や、核爆弾の開発から反省しないのであれば、覇権国家の役には立っても、人類の絶滅の役に立ったとしても不思議ではない。

いまだ未熟な機械学習技術への幻想を払いのけることは重要だとしても、批判ばかりしていたのではチャンスを逃すことになりかねない。GAFAが実効支配するインターネットには、ネット犯罪が氾濫し、公共サービスや信頼性のあるサービスを提供することが困難になっている。IT技術の発展によって、全ての産業がサービス産業化している現状では、インターネットのセキュリティーの低さが、産業発展の足かせとなっている。そこで、暗号資産のブロックチェーン技術を組み込んだWeb3.0や、日本の内閣官房デジタル市場競争本部が推進している「Trusted Web」など、次世代インターネットの技術基盤が模索されている。機械学習を頭脳とするAI技術は、GAFA(+Microsoft)がリードして、インターネット上で実用化しているので、次世代インターネットの技術基盤は、GAFAMに対抗するチャンスであり、GAFAMとは異なる発想で、次世代AI技術を実用化する可能性がある。拙稿では、個体差を積極的にモデル化する新規な機械学習法フェノラーニング®の産業応用を模索しているので、このようなチャンスを見逃したくはない。

従来の発想では、個体差は母集団の平均からの差異として、誤差項のような取り扱いで、例外的な個人を発見したり、個人向けのサービスを提案することは出来ても、個人と全体の問題しか取り扱うことができない。ミクロ経済学とマクロ経済学のようなもので、その中間の組織の経済学や、業界の経済が欠落している。哲学的には、個体差とは個体差の表現の個体差であるというテーゼにおいて、個体差を増幅する仕組みである表現が、表現の場(集団)を必要としているという発見が、フェノラーニング®の出発点になっていて、自然に集団が個体の問題に導入される。個人(や法人)と全体(国家)の中間項としての、地域や業界団体の役割が、「表現」を考えることで、明示的に機械学習に組み込むことができる。例えば、ある業界団体に属する200の企業のホームページを(機械)学習して、ほぼ共通に見いだされる表現を抽出できれば、その表現変数を予測するデータ群を業界標準のデータモデルとする。このように業界標準のデータモデルを定義して、各企業がデータをホームページに添付すれば、その業界内でフェノラーニング®による機械学習が可能になる。そのデータは特許の出願数や国際分類かもしれないし、決算書の一部分かもしれない。各社のホームページにおける特徴的な表現と標準化されたデータの関係を、機械学習が随時計算しているので、不正アクセスを即時発見できるし、業界としての創意工夫があるディレクトリーサービスを自動的に提供できる。地域や業界団体による中間層のデータモデルは、より広域なデータモデルにくりこむことも可能で、多重なデータ定義が与えられ、社会的な意味でデータ(ホームページ表現)の信頼性が醸成されるようになる。

昨今のデータサイエンスを、いかがわしく見過ごしている人びとが大多数だろう。しかし、ぜひ関心を持って、批判的に自ら学習して、未来にコミットしてもらいたい。データサイエンスは実学であって、量子力学のように難解なものではない。今日、データサイエンスを一部の専門家(または野心家)に任せてしまえば、未来が変質してしまうかもしれない。近代文明は、地球上の未開地と原住民を、自分の理解できる領域に限定して、その他は排除してきた。単純に言えば、殺戮(さつりく)の歴史だ。自分自身の無知との引き換えにしては、歴史的にも倫理的にも正当化することは出来ない。政府が発表する戦死者の数ではなく、その数字がゼロではないことの意味を考えてもらいたい。データの世界は、人間中心ではないけれども、人間ひとりを見過ごすこともない。データの世界において、個体差を重要視するかしないかは、文明の岐路になると思う。

--------------------------------------

『みんなで機械学習』は中小企業のビジネスに役立つデータ解析を、みんなと学習します。技術的な内容は、「ニュース屋台村」にはコメントしないでください。「株式会社ふぇの」で、フェノラーニング®を実装する試みを開始しました(yukiharu.yamaguchi$$$phenolearning.com)。

コメントを残す